Meta Llama 3 正式发布!如何在线体验和本地安装部署?

Meta 宣布推出下一代开源大语言模型Llama 3,标志着AI发展新里程碑。该模型分为80亿和700亿参数两个版本,被誉为”Llama 2的重大飞跃”,为大规模语言模型树立新标杆。

值得一提的是,Llama 3已与Meta AI助手深度集成,未来还将陆续在AWS、Databricks、Google Cloud等多个云平台上线,并获得AMD、Intel、NVIDIA等硬件厂商的支持,进一步扩大应用场景。

该模型的发布彰显了Meta在开源AI领域的决心和影响力。我们有理由期待,Llama 3将为自然语言处理、机器学习等AI前沿技术的发展注入新动力。

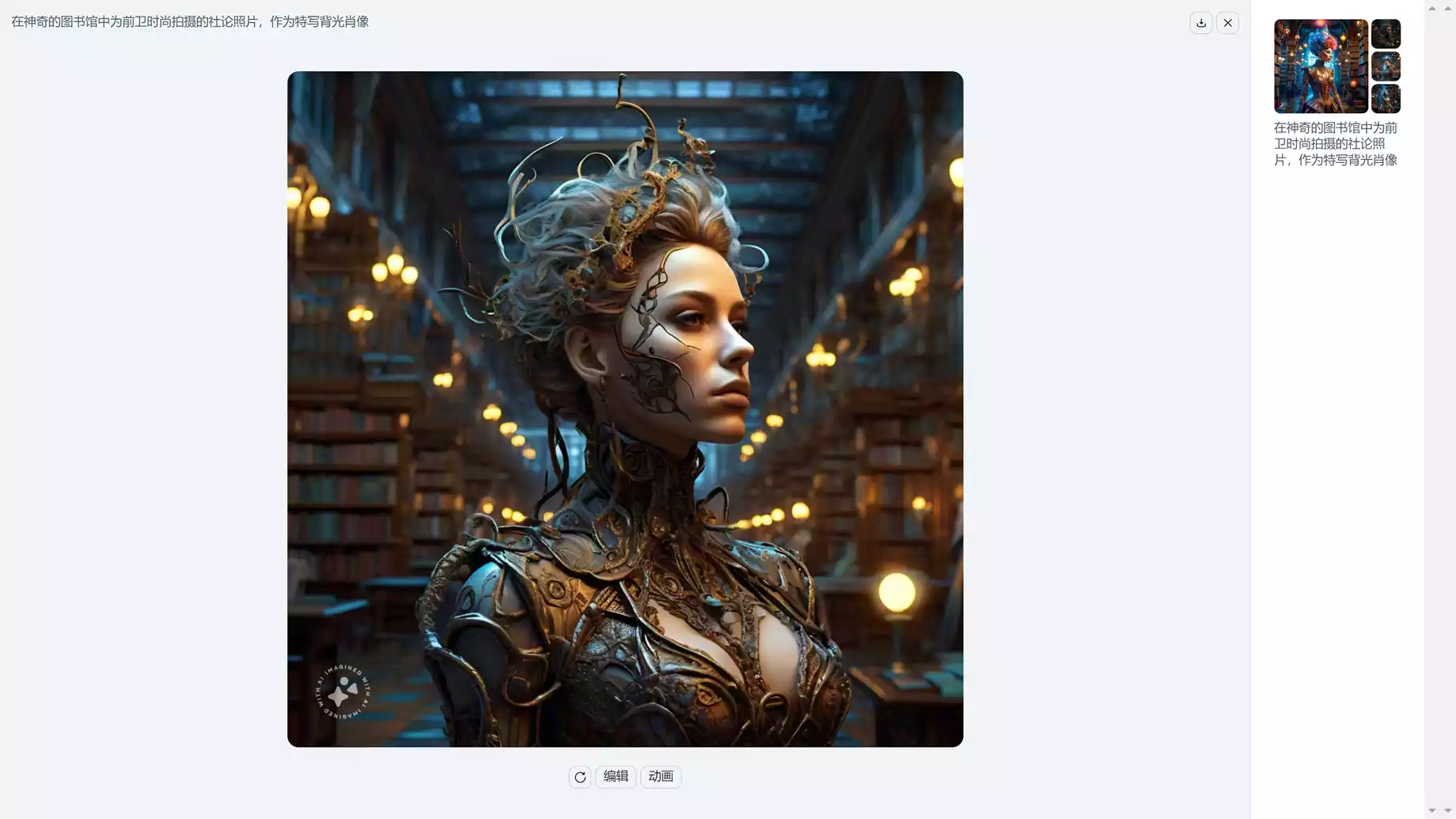

在线使用:【链接直达】

不仅可以智能对话,也可以在线生成图片

本地安装部署:

1.从github下载Llama 3 项目文件

【点击下载】

2.申请模型下载链接 (申请秒过)

【点击申请】

申请后会在邮件里提供一个下载链接

3.安装环境依赖

在Llama3最高级目录执行以下命令(建议在安装了python的conda环境下执行)

pip install -e .

4.下载Llama3模型,执行以下命令:

bash download.sh

运行命令后在终端下输入邮件里获取到下载链接,并选择你需要的模型,比如我选择8B-instruct

5. 运行示例脚本,执行以下命令:

torchrun --nproc_per_node 1 example_chat_completion.py \

--ckpt_dir Meta-Llama-3-8B-Instruct/ \

--tokenizer_path Meta-Llama-3-8B-Instruct/tokenizer.model \

--max_seq_len 512 --max_batch_size 6

本文链接:https://www.apahu.com/553.html

免责声明:本文出现的内容仅用于学习参考,请勿用于非法用途。

版权声明:本站文章资源均源自互联网整理,如侵权请联系处理。

THE END